Jan 2025 /

WEB-APP

( what i used )

( credits )

Frau Silke Hilsing

Technische Hochschule Augsburg

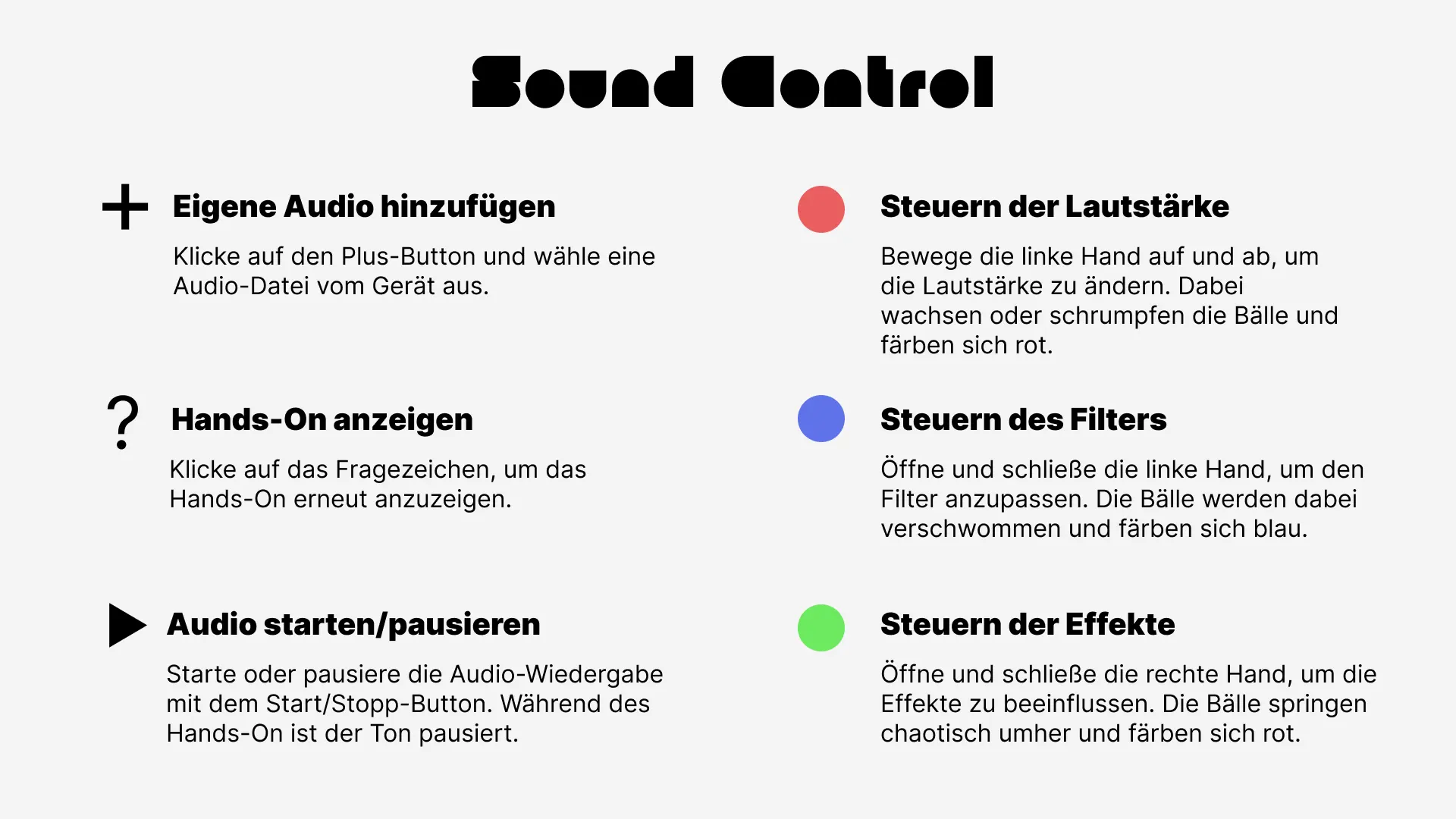

Das Projekt widmet sich der Frage, wie Handgesten als intuitives Interface für die Steuerung von Klang eingesetzt werden können. Ziel ist es, ein System zu entwickeln, das Handbewegungen in Echtzeit erfasst, diese in Soundparameter übersetzt und visuelles Feedback bietet.

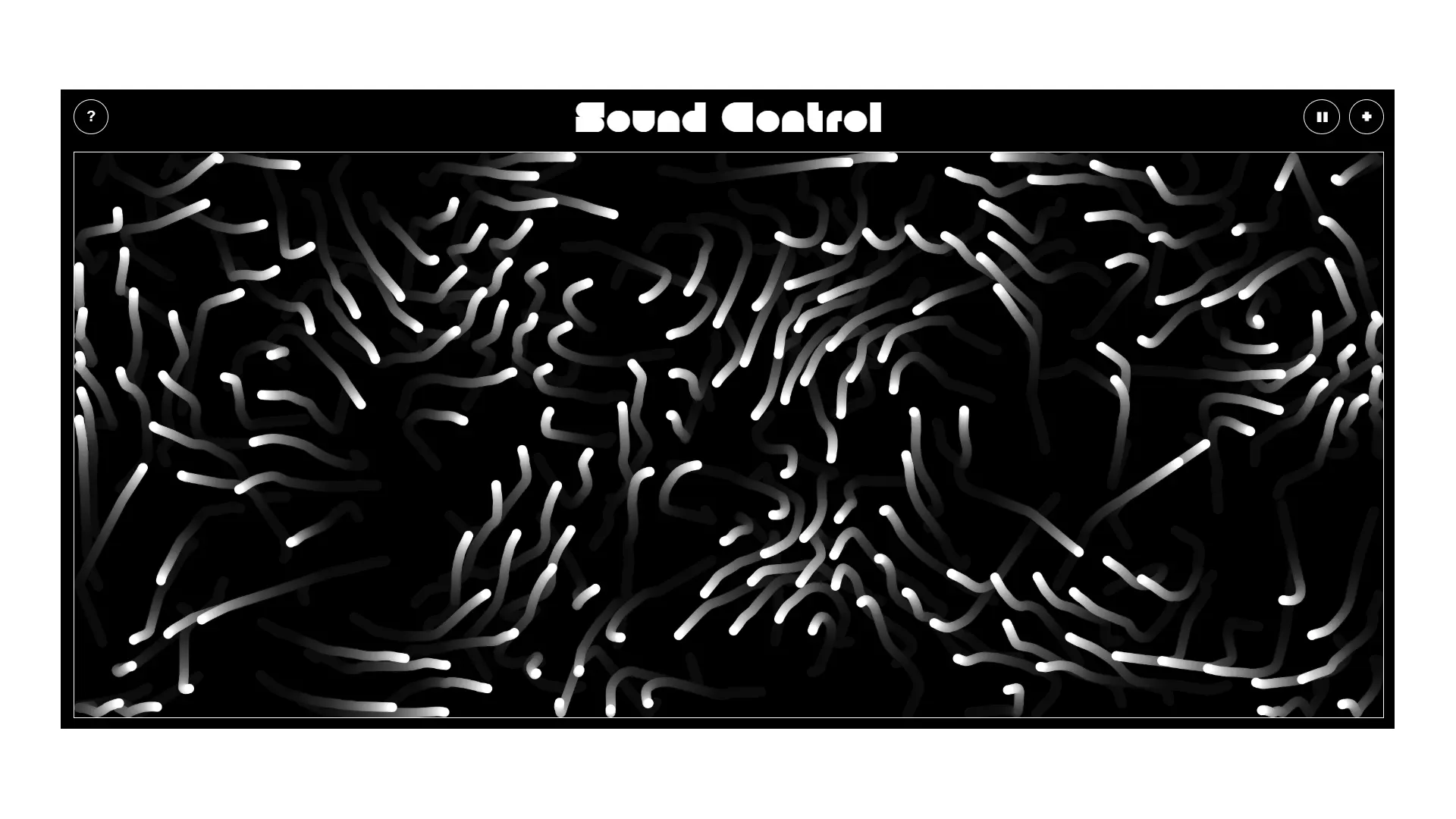

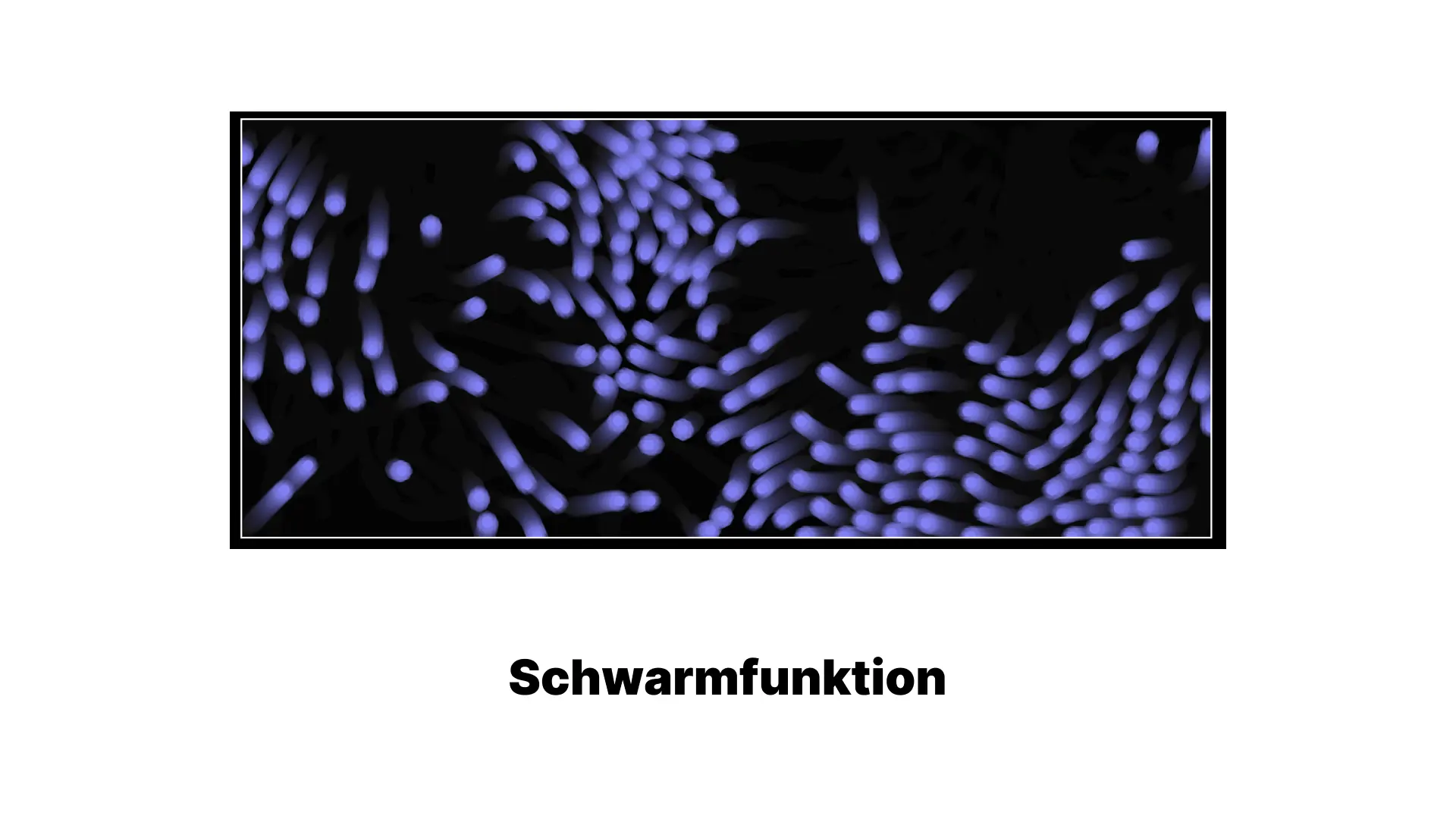

Der Prototyp verbindet Gestenerkennung mit dynamischer Klangsteuerung und bietet eine minimalistische, klare Oberfläche. Über Gesten lassen sich Klangparameter wie Lautstärke und Effekte intuitiv verändern, ohne physische Regler oder komplexe Interfaces zu verwenden. Dies eröffnet neue Möglichkeiten für spontane und kreative Interaktionen mit Musik.

Die technische Umsetzung basiert auf der Gestenerkennung von Google Mediapipe mittels Kamera sowie der Web Audio API für die direkte Soundbearbeitung im Browser. Damit wird ein System geschaffen, das Musikern und Produzenten neue kreative Freiheiten bietet – sei es im Studio, bei Live-Auftritten oder in experimentellen Klangprojekten.

Durch die Kombination von Gestensteuerung, visueller Darstellung und Echtzeit-Klangmanipulation entsteht ein Interface, das nonverbale Kommunikation auf innovative Weise integriert. Es zeigt, wie digitale Technologien zu intuitiven, flexiblen und experimentellen Formen der Musikinteraktion beitragen können.